想玩玩ds-r1,在ollama网上的ds-r1有28个模型

14b-q_4和7b-q8 哪个效果会好一些?

我觉得ds很鸡贼,这些distill模型应该不会比llama,qwen这样的base模型好多少吧,但是现在造成的舆论(至少我在网上随便看看帖子的感受)就是r1很牛,而且本地就能跑。 但事实上本地能跑的和所谓能和openai比肩的完全不是一个东西。然后本地能跑的这些模型和别的公司开放的模型也差不太多(正打算用ollama试试)。 我理解的对吗?

参数多 vs quantize少

版主: verdelite, TheMatrix

-

TheMatrix

- 论坛支柱

2024年度优秀版主

TheMatrix 的博客 - 帖子互动: 279

- 帖子: 13704

- 注册时间: 2022年 7月 26日 00:35

#2 Re: 参数多 vs quantize少

deepseek牛在降低成本。无论是本地的还是online的。bullogger 写了: 2025年 2月 4日 02:29 想玩玩ds-r1,在ollama网上的ds-r1有28个模型

14b-q_4和7b-q8 哪个效果会好一些?

我觉得ds很鸡贼,这些distill模型应该不会比llama,qwen这样的base模型好多少吧,但是现在造成的舆论(至少我在网上随便看看帖子的感受)就是r1很牛,而且本地就能跑。 但事实上本地能跑的和所谓能和openai比肩的完全不是一个东西。然后本地能跑的这些模型和别的公司开放的模型也差不太多(正打算用ollama试试)。 我理解的对吗?

-

TheMatrix

- 论坛支柱

2024年度优秀版主

TheMatrix 的博客 - 帖子互动: 279

- 帖子: 13704

- 注册时间: 2022年 7月 26日 00:35

#4 Re: 参数多 vs quantize少

对。质量也很好。质量不好的话成本再低也没有意义了。bullogger 写了: 2025年 2月 4日 10:21 不光是成本低吧?它能达到chatgpt o1的水平,说明质量也好吧。 我可能一厢情愿地觉得local版的也会比别的同样大小的开源模型好了

#5 Re: 参数多 vs quantize少

我觉得7-32b的蒸馏模型都差不多 具体表现得看给什么任务。 ds一个缺点是极其啰嗦, 所以我配合mistral-small ,qwen和llama 一起玩。 同一个问题,几个模型轮流答, 谁的答案好就用谁。

真正的ds-r1 应该是只能去他网站用了 我没试过。

真正的ds-r1 应该是只能去他网站用了 我没试过。

#6 Re: 参数多 vs quantize少

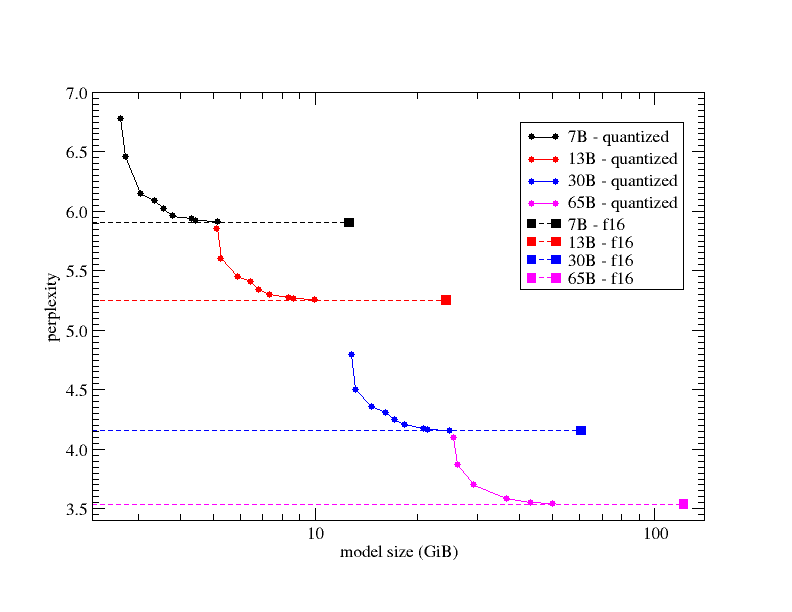

前几天看到一个图,画的是模型perplexity对quantization以及参数总数的变化情况。但是perplexity具体跟性能怎么挂钩我就不知道了。

#7 Re: 参数多 vs quantize少

huangchong 写了: 2025年 2月 15日 12:49 前几天看到一个图,画的是模型perplexity对quantization以及参数总数的变化情况。但是perplexity具体跟性能怎么挂钩我就不知道了。

https://github.com/ggml-org/llama.cpp/pull/1684

https://qwen.readthedocs.io/zh-cn/stabl ... a.cpp.html